使用 TensorFlow/Pytorch/Theano 实现 AlphaZero 算法,通过自我对弈从零训练五子棋 AI。实现简单、清晰,适合学习、了解 AlphaGo Zero 背后的关键思想和技术细节

项目分析

仓库名称:AlphaZero_Gomoku

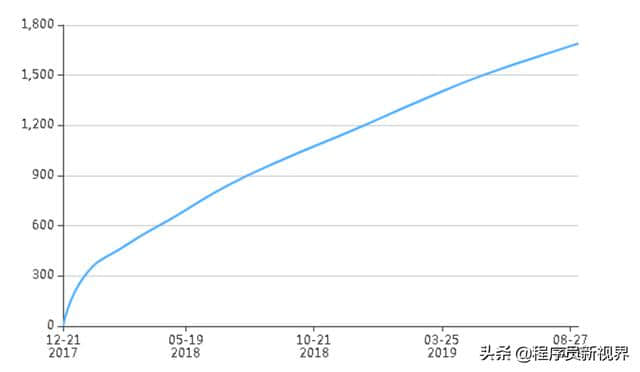

标星(star):1690 (网红级项目,高手作品,star可以走一波)

标星趋势

关注(watch):97

拷贝(fork):575

贡献人数:8

仓库大小:6 MB

最后更新:

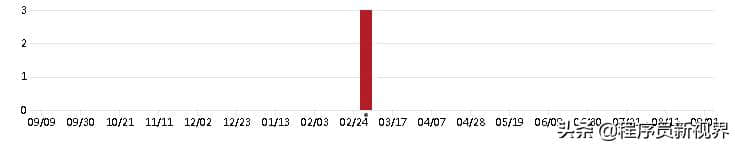

代码提交周期分布:

综合推荐指数: 2星半

开发语言

主要语言:Python

语言分布:Python:100.00%

项目概述

入门

要使用提供的模型,请从目录运行以下脚本:

python human_play.py

您可以修改human_play.py以尝试不同的提供模型或纯MCTS。

要从头开始训练AI模型,使用Theano和Lasagne,直接运行:

python train.py

使用PyTorch或TensorFlow,首先修改文件train.py,即注释该行

from policy_value_net import PolicyValueNet # Theano and Lasagne

并取消注释该行

# from policy_value_net_pytorch import PolicyValueNet # Pytorch

or

# from policy_value_net_tensorflow import PolicyValueNet # Tensorflow

然后执行:( python train.py 要在PyTorch中使用GPU,如果你的pytorch版本大于0.5,请在policy_value_net_pytorch.py中的函数train_step中设置use_gpu=True和使用return loss.item(), entropy.item())

模型(best_policy.model和current_policy.model)将在每次更新时保存(默认为50)。

项目地址

https://github.com/junxiaosong/AlphaZero_Gomoku

程序员新视界:分享有趣、有料的流行程序员话题,每天进步一点点。