编者按:Uber自动驾驶汽车撞人致死事件发生后,很多人都持有这样的一个观点:在将来大规模部署自动驾驶汽车的世界里,撞人致死的事件将会大幅度减少。因此,要理性看待这次车祸事件,并将其当作是技术发展中必然要付出的代价。从某种意义上来说,这非常像一个电车难题。为了将来拯救更多人,现在杀死少数人是合理吗?很多人用行动给出了答案。但是,在伊恩 · 博格斯特(IAN BOGOST)看来,Uber的自动驾驶汽车并不能用电车难题来进行解释,这次事故的发生,更像是一个醉酒驾车的人撞人致死事件。我们应该从更加实际的角度来审视这个问题。文章发表在《大西洋月刊》,由36氪编译。

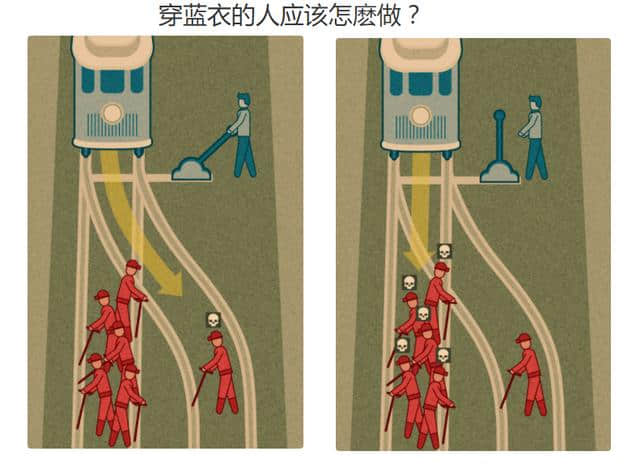

关于电车难题,你可能并不陌生:一辆失控的电车正沿着一条轨道向下冲去。轨道前方有五个工人, 如果电车冲过去,他们肯定会被撞死。但你可以用一个操纵杆把电车转向邻近的轨道上,但是那个轨道上也有一个工人,如果电车冲过去了,他也同样会被撞死。你是让电车变换轨道撞死一个人,还是什么都不做,让它撞死五个人?

这是电车难题最著名的版本,一个在20世纪70年代普及开来的哲学思想实验。它还有其他变体:比如你是否愿意把一个胖子从桥上推下来,让电车停下来,而不是杀死那些较瘦的工人?电车难题除了作为一个哲学实验外,还被用作心理学实验中的一种工具——最近,人们已经把它当作衡量自动驾驶汽车的道德标准了。

自动驾驶汽车应该优先保护行人还是先保护乘客?那老人与小孩相比呢?如果汽车可以获得与车祸发生相关的信息,它是否应该使用这些数据来做出决定?电车难题已经在自动驾驶汽车领域流行起来了。事实上,麻省理工学院的工程师们已经建立了一个名为“道德机器”(Moral Machine)的测试,旨在记录人们对自动驾驶汽车在各种条件下应如何反应的看法。

但是,用电车难题来理解当前的自动驾驶汽车是存在问题的。它在解决自动驾驶汽车或工人的道德问题上做得非常糟糕。为这些目的部署它,尤其是将其作为工程上或政策制定上的答案或参照,会让机器道德变得不完整或者更加危险。

哲学家朱迪思·贾维斯·汤姆森(Judith Jarvis Thomson)在1976年创造了“电车难题”。不过,这一设想最早是由另一位哲学家菲利帕•福特(Philippa Foot),在1967年发表的论文《堕胎问题和教条双重影响》中提出的,他认为,人们的意图和他们所能预见的东西之间是有区别的。福特以堕胎为例, 外科医生对一名孕妇进行子宫切除术时,能预见到婴的儿死亡,他应该这么做吗?与此同时,一位外科医生为了挽救母亲的生命而终止了胎儿的生命,应该这样做吗?虽然案例非常相似,但最后得出的道德结论却不尽相同。

福特提出了许多相关的场景, 其中之一就是现在著名的电车难题。 另一种假设是, 一群暴徒威胁说,如果法官不处决一个无辜的人,他们就会报复,杀死更多的人。法官该怎么办?这看起来似乎是一个电车难题——在更多或更少的死亡之间做出选择。 但是,大多数支持电车操纵员撞死一名工人的人,也会对陷害无辜的人感到震惊,福特写道。

她的结论是, 一个人做什么和一个人被允许做什么是有区别的。福特写道, 特别是“避免伤害和提供援助之间的区别确实非常重要。”

福特的简短论文为当代读者提供了一种更细致入微的方法,来思考涉及自动驾驶汽车的道德场景,而不是只用所谓的电车难题来分析。 在某种程度上,这是因为福特遵循了在亚里士多德之后一种被称为道德伦理的传统。

但是,遵循道德规范并不会引发目前大多数关于自动驾驶汽车的争论。相反,对最终结果是自动驾驶汽车占主导的社会的关注,是最令人担忧的。在道德哲学中,这种不同于道德伦理学的方法被称为结果主义。结果主义者——包括最著名的功利主义者——首先关心的是行为的结果和后果。

这种功利主义思想已经深深植根于自动驾驶汽车的修辞之中。甚至,在自动驾驶汽车的拥护者们开始决定车祸发生时撞谁之前,就已经存在了。推动自动驾驶车辆大规模采用的一个共同理由是,它们能把道路上的安全性大幅度提高。2016年,美国有37000多人死于车祸。由于94%以上的车祸都是由司机的错误造成的,用可靠的机器代替容易出错的人,对于社会来说,显然具备净效益。

问题是,把注意力集中在结果上,可能会使人们对自动驾驶汽车的优点和缺点视而不见。 正如福特提出的,工人面对电车难题和法官面对暴徒威胁的道德场景是不同的。因此,同样的以人为代价的自动驾驶汽车的结果,可能会带来截然不同的道德、法律和公民后果。

最近, 亚利桑那州坦佩市的一辆Uber的自动驾驶汽车撞死了49岁的伊莱恩 · 赫茨伯格(Elaine Hertzberg)——一个骑着自行车过马路的行人。 在我写下关于这场车祸可能产生的法律影响的文章之后, 一些读者以功利主义的冷笑回应。 毕竟,2015年美国有5376名行人被汽车撞死, 新闻媒体也不会把每一个人都当作特例来报道。 很快, 自动驾驶汽车可以减少或消除行人死亡。 如果你用电车难题的术语来说,轨道代表的是时间而不是空间。一个人死亡仍然是一个悲剧。但如果她的死亡,意味着在预防成千上万个人死亡方面取得进展,那么也许这是合理的。

问题在于, 这种立场的假设是,赫茨伯格的死与普通的汽车造成的数千人的死亡完全相同。 从统计学上来说, 这可能是正确的, 但从道德上讲, 并不一定如此。

在未来,如果它们能有效地运行,自动驾驶汽车就有可能预防像坦佩市这样的车祸事故了。传感器和计算机对周围环境的反应比人类更好,也会表现得更加理性。 随着Uber这次车祸的细节逐渐浮出水面,一些专家得出结论,这次车祸本来是能够避免的。此外,Uber的自动驾驶汽车似乎没有达到公司的目标,即在3月份发生车祸时,每行驶13英里的路程只需要人为干预一次。与此同时,谷歌的兄弟公司Waymo声称,它的自动驾驶汽车在不需要人为干预的情况下,平均可以行驶5600英里。

那么, 在亚利桑那州的道路上,Waymo的自动驾驶汽车和Uber的自动驾驶汽车之间的区别,可能比人操作汽车和计算机操作汽车之间的区别更重要。但是,为了吸引更多的公司到亚利桑那州研究、测试,从而推动就业。亚利桑那州州长道格·杜西(Doug Ducey)允许在没有重大监管的情况下,让所有的这类汽车上路测试。

这些条件的存在,决定了不能从电车难题的角度来考虑这个问题。如果要问Uber是否应该撞上赫茨伯格还是突然转向(让安全员员面临危险,避免行人被撞),则需要假定Uber的车辆可以先看到行人并做出相应的响应。需要假定这种能力是可靠和有保证的——相当于一种机械行为,就像切换电车轨道那样。这种背景,在发生在坦佩市的车祸事故中消失了。

不过,福特已经预料到了在她的案例中背景缺失的情况。“在现实生活中,”她写道,“很难确定电车转向后,站在轨道上的那个人会被杀死。 也许他会在车身侧面找到一个立足点,并在车辆驶过时紧紧抓住。”解决这种无限可能性的一种方法是运行无限的电车难题,从公众对这些问题的反应中收集模式。这就是麻省理工学院道德机器的方法,它与机器学习系统工作的最佳方式相匹配:使用大数据集。但还有一种办法——在最适当的道德背景下考虑具体问题。

碰巧的是, 福特也提出了一个不同的例子, 与电车难题相比,这个例子与坦佩市实际发生的事情有更多的共同点。 想象一下, 在医院里有五个病人。 通过使用某种气体可以挽救他们的生命, 但是使用这种气体,会向另一个无法移动的病人的房间里释放致命的烟雾。 在这种情况下, 产生的后与经典的电车难题是相同的。然而,对许多人来说,结果并不那么明显。这仅仅是因为预期效果和可预见的效果之间的差别,也是因为避免伤害,导致的道德欲望有着不同的运作方式。

在电车难题中,司机面临两种相似的伤害之间的矛盾,没有其他的选择。但在医院的气体例子中,医生面临着提供援助和造成伤害之间的矛盾。事实上,Uber的情况更为棘手,因为所有参与方——不管是汽车制造公司、驾驶它的司机还是监管它的政府——似乎都没有充分了解车辆目前(而不是未来)造成损害的能力。这使得 Uber这场事故的道德背景不再是关于未来减少车祸,更多的是关于政府监管、公司信息披露和交通政策的现状的问题。但是,这些话题远不如一辆失控的电车更吸引人。

如果这是技术专家、公民和政策制定者真正想要的道德哲学的先例。那么,他们最好把Uber的这场车祸看作是一个关于道德运气(moral luck)的例子,这是哲学家托马斯·内格尔( Thomas Nagel )提出的一个观点。有一个经典的例子:

一个喝醉的人晚上开车回家。虽然喝醉了,但他最后还是毫无意外地到达了目的地。然后想象另一个场景。一个人在同样的情况下开车的时候, 但他意外撞死了一个过马路的孩子。

认为后者比前者更应受责备似乎是理所当然的,但两人都采取了同样的自愿行动。唯一不同的就是结果。

从这个角度来看,Uber带来的车祸并不代表一种价值中立,更不是所谓的正义:牺牲一个行人,来确保有效部署自动驾驶汽车的世界里确保更多人的安全。相反,它强调了这样一个事实,即积极的结果——更安全的汽车、更安全的行人等等——很容易成为自动驾驶汽车的道德运气的一部分,因为它没有犯下一个应受谴责的行为。当然,现在不是了。

道德运气也为自动驾驶汽车开辟了其他的审议途径。在自动驾驶汽车的情况下,自愿行动更难确定。Uber的司机是否知道并理解他们行为的所有后果?假设人类驾驶员可以干预其正在观察的机器的操作而不是主动操作,这种假设是否合理?在亚利桑那州明确邀请自动驾驶汽车在实际道路上进行实验性的测试的情况下,Uber是否也应受到谴责?所有这些问题现在都在亚利桑那州和其他地方被问及。 但这对伊莱恩·赫茨伯格来说,只是一种冷漠的安慰。

这一切的意义并不在于指责或赞扬最近Uber车祸中的特定行为者。也不是为了庆祝或哀叹自动驾驶汽车的未来。相反,这表明,无论是现在还是将来, 解决和应对自动驾驶汽车需要更高的道德修养。

道德不是将简单的计算应用于任何情况下的问题,也不是将人类对一个模型案例的一整套意见应用于在整个模型下的实例问题。事实上,采取这些立场从一开始就能得出功利主义的结论。当工程师、评论家、记者或普通人,把电车难题当做是一个非常适合(或许是为了方便)思考自动驾驶汽车问题的时候,他们拒绝考虑这些机器操作的更复杂的道德状况。

对于哲学家来说,思想实验提供了一种考虑未知结果或重新考虑已接受的结果的方法。但它们只是思考的工具,而不是现成行动的指南。特别是,电车难题的普及,让人们误认为自动驾驶汽车是一种已经存在、可靠、同质的技术——这样就可以提出、甚至回答关于其假想道德行为的抽象问题。但是,想要这种情况发生,还需要等上好几年。与此同时,公民、政府、汽车制造商和科技公司,必须就自动驾驶汽车在今天和明天可能产生的道德后果,提出更困难、更复杂的问题。是时候在电车把所有人撞死之前踩刹车了。

原文链接:https://www.theatlantic.com/technology/archive/2018/03/got-99-problems-but-a-trolley-aint-one/556805/

编译组出品。编辑:郝鹏程

- 上一篇:吉利GC9博瑞定价20万,你买吗?-博瑞gc9

- 下一篇:没有了